早上刷手机的时候突然看到条热搜,标题挺抓眼,说谷歌高管因为AI画不出白人出来道歉了。我当时正喝咖啡,差点呛着——谷歌的AI画画工具我前几天还用过,没想到闹这出。赶紧点开详情页扒拉。

追事件源头

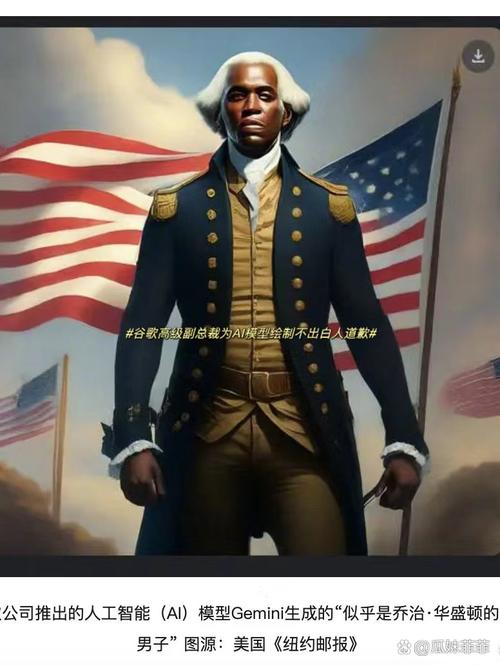

顺着几个科技博主的转发链摸到原始报道。原来是谷歌图像生成工具Gemini被网友测试,输入“18世纪英国国王”“美国开国元勋”这种关键词,生成的全是黑人形象。有人较真儿,连着试了十几次“白人夫妻”“金发美女”这种直白描述,结果出来的要么肤色偏深,要么直接塞进有色人种面孔。

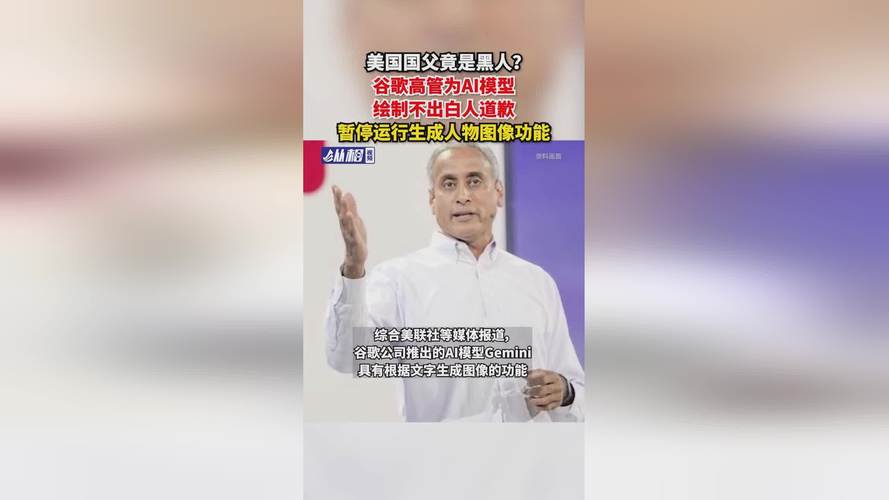

更离谱的是,有人让AI画“1943年德国士兵”,生成图里居然混进个黑人女兵,穿纳粹军装还顶着深色皮肤——好家伙,历史事实都敢魔改!事情闹大后,谷歌搜索部门高管只好发声明认错,承认“过度调整了多样性机制”。

爬网友评论

好奇心被彻底勾起来了,我花了俩小时翻遍海外平台热门讨论区。网友反应特别有意思,基本分成几类:

- 段子手型:有人把AI生成的彩色版华盛顿做表情包,配文“当你政审不合格但KPI达标了”,还有人说“下次让Gemini画根香蕉,可能直接长出黑人兄弟的脸”。

- 愤怒派:不少欧美网友骂得特难听,说这是“逆向歧视”“科技界白左癌晚期”。有个老哥晒出自己连刷27次“白人高中生踢足球”的生成图,愣是没出现一张白脸,气得他骂谷歌“该去治眼睛”。

- 阴谋论党:评论里还藏着不少技术分析党,有人扒出去年谷歌内部文件泄密截图,显示公司要求图像产品“确保20%生成为深肤色人群”——现在看这比例可能被悄悄调得更高。

本地社区观察

顺手点开国内论坛,发现这边更关注技术漏洞。有程序员分析说这是数据标注的灾难现场:“训练时疯狂打‘避免种族刻板印象’标签,AI怕犯错干脆一刀切,看见白人关键词都绕着走”。还有人吐槽谷歌把AI当幼儿园小朋友管:“左脸挨了拳就拼命护左脸,结果右脸肿成猪头”。

最逗的是微博评论区,有人甩出国内某绘图软件生成的“唐朝美人图”——满头珠翠配蕾丝裙,脚上还蹬耐克鞋。热评第一说:“得了,咱们的AI连朝代都能混搭,谷歌至少没给华盛顿穿龙袍!”

我的实践笔记

下班前我自己也拿几个主流AI绘图工具做测试。输入“程序员写代码”,某国外工具生成清一色亚裔眼镜男;换成“护士”又全变成白人女性——合着谁都没跳出刻板印象,只是谷歌用力过猛翻车翻得最轰动。

关电脑前突然想到去年小区换物业。新物业怕被投诉“清洁不周”,让保洁每天刷三次垃圾桶,结果垃圾车来不及清运,反而招来更多老鼠。这和谷歌的失误多像——解决问题时只盯着一个指标猛调,迟早在其他地方爆雷。

睡前发了条私密笔记:“搞技术别学物业刷垃圾桶,平衡木玩砸了,摔得最惨的往往是喊口号最大声的。”